-

StyleGAN 1~3 논문 리뷰공부/논문 2024. 3. 19. 17:10728x90

StyleGAN1

https://arxiv.org/abs/1812.04948

A Style-Based Generator Architecture for Generative Adversarial Networks

We propose an alternative generator architecture for generative adversarial networks, borrowing from style transfer literature. The new architecture leads to an automatically learned, unsupervised separation of high-level attributes (e.g., pose and identit

arxiv.org

Abstract

quantify interpolation quality and disentanglement

1. Introduction

process나 latent space와 같은 것들을 이해하지 않고 그동안은 black box처럼 여겨져왔음

generator는 학습된 constant input으로부터 시작되었고, latent code를 기반한 convolution layer의 "style"이미지를 조정

네트워크로 직접 주입된 노이즈와 결합된 구조적 변경은 automatic하고 비지도적으로 확률적 분포로부터 high-level 속성의 분리를 이끌고 scale이 특정한 결합과 interpolation작업을 가능하게 함

discriminator, loss function은 바꾸지 않았음

generator는 latent space에 latent code 입력을 임베딩함(분산의 요소가 네트워크에 어떻게 나타나는지에 대한 영향을 표현하기 위해)

input latent space는 훈련 데이터셋의 확률밀도를 따라야하는데 여기서는 latent space는 그런 제한에서 free함

2. Style-based generator

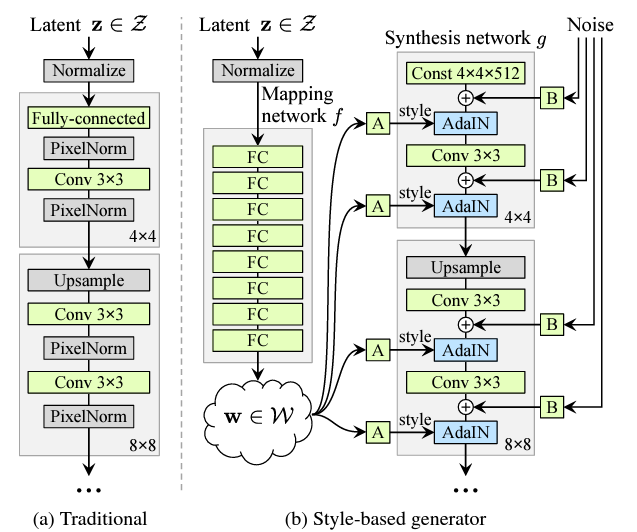

latent code는 input layer(feedforward 네트워크의 첫번째 layer)를 통해 G에게 제공

하지만 여기서는 input layer를 완전히 생략하고 학습된 상수에서 시작하여 해당 아키텍처를 벗어남

input latent space Z에 latent code z가 주어지면, nonlinear mapping network f:Z=>W는 w를 생성

단순화를 위해 두 공간의 차원을 512로 설정, 8개의 FC MLP layer사용, AdaIN연산(효율성, 간결한 표현을 위해)

벡터 w로부터 공간적으로 불변하는 style y를 계산

노이즈(상관관계가 없는 가우스 노이즈로 구성된 단일 채널 이미지)입력을 도입하여 G가 디테일을 생성할 수 있도록 함

3.Properties of the style-based generator

style에 대한 스케일별 수정을 통해 이미지 합성 제어

mapping network와 Appin transformation은 학습된 분포에서 각 스타일에 대한 샘플을 추출

convolution network는 style collection을 기반으로 새로운 이미지를 생성

3.1. Style mixing

style을 더 잘 적용하기 위해 이미지의 일정 비율을 1개가 아닌 2개의 random latent code를 사용하여 생성하는 mixing regularization사용

convolution network에서 random으로 선택한 지점에서 하나의 latent code에서 다른 latent code로 transform하는 것을 style mixing이라고 함

mapping network를 통하여 latent code z1,z2가 실행되고, 해당 w1,w2가 style을 control

crossover point 앞에는 w1이, 뒤에는 w2가 적용되도록 함=>이 정규화로 인하여 네트워크가 인접한 style이 상관관계가 있다고 가정하는 것을 방지함

=>mixing regularization을 활성화하여 localization이 향상됨

3.2. Stochastic variation

network에 유일한 입력이 input layer를 통해서만 이루어지기 때문에 network는 필요할 때마다 이전 activation에서 공간적으로 변화하는 presudo random number(의사 난수)를 생성하는 방법을 개발해야함

=>network의 용량을 소모하며 반복적인 패턴을 보임

=>각 convolution 후, 픽셀 당 노이즈를 추가함으로써 회피함

노이즈를 추가하면 확률적 측면에만 영향을 미치고 전체적인 구성과 identity와 같은 높은 수준의 측면은 그대로 유지

presudo random number(의사 난수)추가하여 high level의 측면은 유지, stocahstic variation만 추가

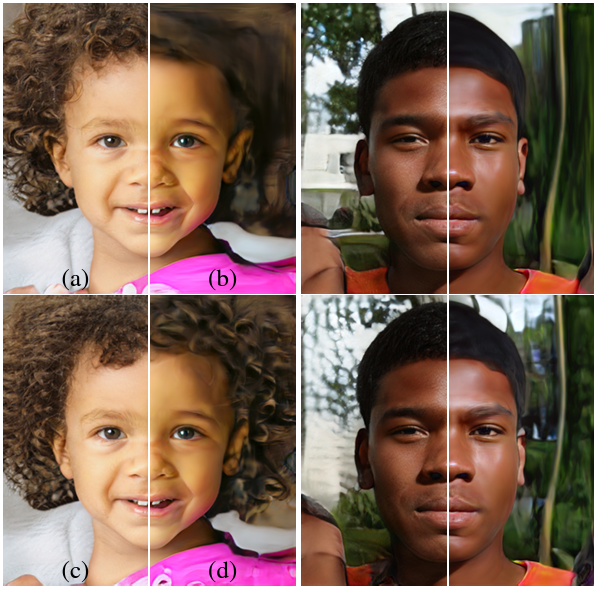

(a)모든 레이어에 noise추가 (b)no noise (c)fine layer(64^2~1024^2)에 noise추가 (d)coarse layer(4^2~32^2)에 noise추가=>coarse layer에는 머리카락, 배경등 크게 바뀜, fine layer은 미세한 디테일 3.3. Separation of global effects from stochasticity

style transfer는 전역적 변화, noise는 미세한 확률적 변화에 영향

style기반 G는 전체 feature map이 동일한 값으로 스케일링되고 편향되기 때문에 style이 전체 이미지에 영향

noise는 각 픽셀에 독립적으로 추가되므로 확률적 변화를 제어하는 데 이상적

4. Disentanglement studies

4.1. Perceptual path length

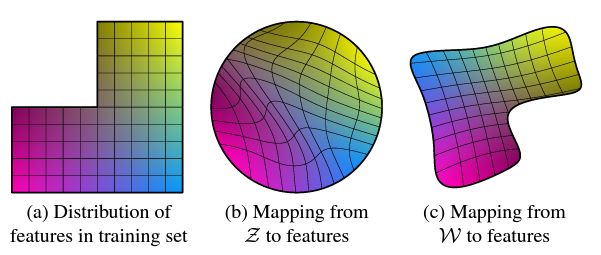

(a)일부 조합이 누락된 훈련세트 (b)잘못된 조합으로의 샘플링을 방지하기 위해 Z에서 이미지 특징에 대한 매핑을 곡선으로 만들어 금지된 조합이 Z에서 사라지도록 함 (c)Z에서 W로 학습된 매핑은 왜곡의 대부분을 취소가능 latent space vector의 interpolation은 이미지에서 비선형적인 변화를 가져올 수 있음

linear interpolation path 중간에 양쪽 끝점에 없는 특징이 나타날 수도...!

=>latent space가 얽혀있다는 것, 변화 요인이 제대로 분리 되지 않았다는 것

이걸 정량화하기 위해 latent space에서 interpolation을 수행할 때 이미지가 얼마나 급격한 변화를 겪는지 측정가능

곡률이 낮은 latent space는 곡률이 높은 latent space보다 더 부드러운 transform을 가져옴

4.2. Linear separability

latent space가 충분히 분리되어 있다면 개별 변화 요인에 일관되게 대응하는 방향 벡터를 찾을 수 있어야함

train dataset distribution을 따를 필요가 없는 중간 latent space를 도입하면 기존 G도 더 나은 성능 발휘

5. Conclusion

StyleGAN2

전통적인 GAN 생성기 아키텍처는 모든 면에서 style 기반 아키텍처보다 열등함

StyleGAN이 짱 먹었다!https://arxiv.org/abs/1912.04958

Analyzing and Improving the Image Quality of StyleGAN

The style-based GAN architecture (StyleGAN) yields state-of-the-art results in data-driven unconditional generative image modeling. We expose and analyze several of its characteristic artifacts, and propose changes in both model architecture and training m

arxiv.org

Abstract

StyleGAN은 데이터 기반 생성 이미지 모델링에서 좋은 결과를 산출

근데 몇 가지 특징적인 아티팩트를 노출했음

이를 분석하고 해결하기 위해 추가적인 모델 아키텍처와 훈련 방법 변경을 제안

G의 정규화를 재설계, 점진적 성장을 재검토

=>latent code에서 이미지로의 매핑에서 좋은 환경을 제공

정규화는 이미지 품질을 개선하는 것 외에도 G가 훨씬 쉬워진다는 이점 제공

생성된 이미지를 특정 네트워크에 안정적으로 합성가능

시각화, 용량 문제 파악으로 추가적 품질개선을 통해 더 큰 모델을 훈련할 수 있는 가능성 제기

1. Introduction

특징적인 아티팩트를 수정하고 결과 품질을 더욱 향상시키는 데 초점

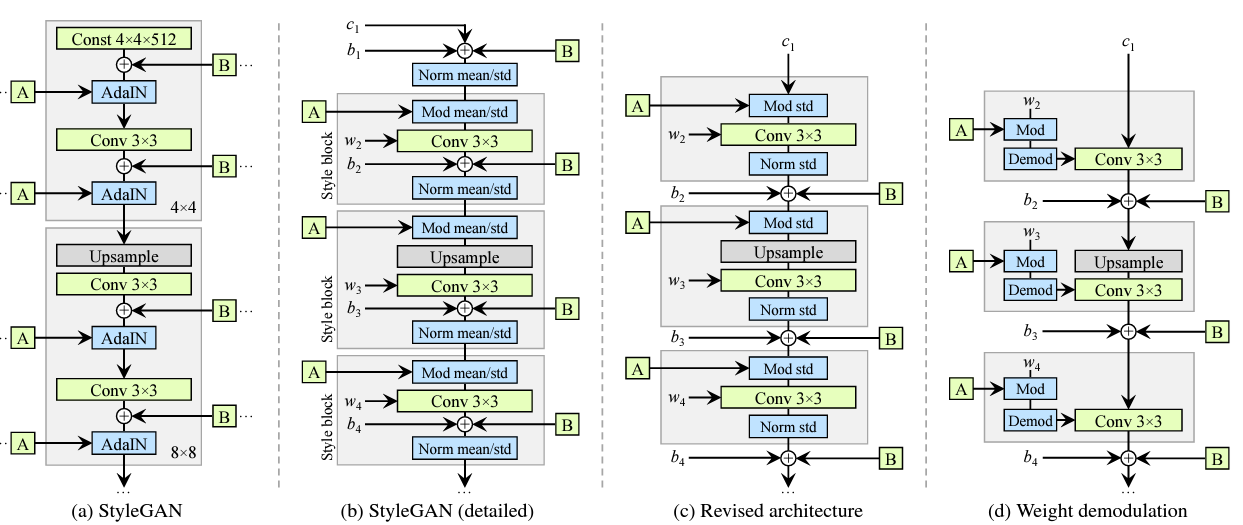

이전버전은 요런 요상한 물방울 아티팩트가 생기는 문제가 있음 2. Removing normalization artifacts

G의 intermediate feature map에 존재

64*64해상도 주변에서 나타나기 시작하며 해상도가 높아질수록 점점 더 강해짐

=>각 feature map의 평균과 분산을 개별적으로 정규화하여 잠재적으로 서로에 대한 특징의 크기에서 발견된 모든 정보를 파괴하는 AdaIN작업에 문제가 있다고 판단

G가 instance 정규화 이후, 의도적으로 신호 강도 정보를 몰래 숨긴 결과라고 가정

=>정규화 단계를 G에서 제거 시, 해당 아피팩트는 완전히 사라짐

2.1. Generator architecture revisited

G의 아키텍처를 수정할 것=>품질 지표 측면에서 비슷하거나 약간 긍정적인 영향을 미침

(a)원래 StyleGAN convolution network (b)가중치와 편향을 표기하고 AdaIN연산을 normalization과 regularization이라는 두가지 부분으로 확장해서 봄각 회색 상자 하나가 하나의 스타일이 활성화된 네트워크 부분을 나타냄 (c)재설계된 architecture 2.2. Instance normalization revisited

StyleGAN의 주요 강점 중 하나는 style mixing을 통해 이미지를 제어하는 기능

inference 시 서로 다른 layer에 서로 다른 latent w를 공급하는 방식

+수식 추가할 것

3. Image quality and generator smoothness

3.1. Lazy regularization

3.2. Path length regularization

4. Progressive growing revisited

'공부 > 논문' 카테고리의 다른 글

Segment Anything (0) 2024.08.03 An Image is worth 16*16 words: Transformers for image recognition at scale (0) 2024.06.06 Prompt-Specific Poisoning Attacks on Text-to-Image Generative Models(Nightshade) (1) 2024.02.22 VERY DEEP CONVOLUTIONAL NETWORKS FOR LARGE-SCALE IMAGE RECOGNITION(VGGNet) (0) 2024.02.18 Generative Adversarial Nets(GAN) 리뷰 (2) 2024.01.11