-

Generative Adversarial Nets(GAN) 리뷰공부/논문 2024. 1. 11. 18:57728x90

https://arxiv.org/abs/1406.2661

Generative Adversarial Networks

We propose a new framework for estimating generative models via an adversarial process, in which we simultaneously train two models: a generative model G that captures the data distribution, and a discriminative model D that estimates the probability that

arxiv.org

Abstract

적대적 프로세스를 통해 생성 모델을 estimate하기 위해 새로운 프레임 워크를 제안

2가지 모델을 동시에 훈련 => Generative model G, discriminative model D

1.Introduction

Deep generative model은 최대우도추정 및 관련 전략이 증가로 인해 다루기 힘든 많은 확률 계산을 근사화하는 어려움과 생성 맥락에서 부분선형함수의 이점을 활용하는 어려움으로 인해 impact가 덜 했음

더보기스티더원들끼리 얘기해본 결과,

생성 맥락에서 부분선형함수(=활성화함수)의 이점을 활용하는 어려움이란 활성화함수는 확률을 예측하는 것이지, 생성형 모델의 목표인 분포를 모사하는 것이 아니기 때문에 활성화함수의 이점(확률 예측)을 활용하는 어려움(분포 모사)가 있다고 생각함

그래서 나온 게 adversarial nets

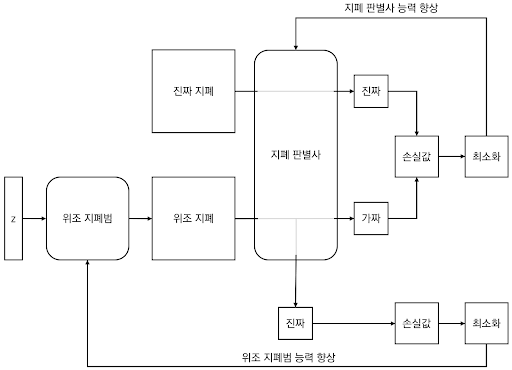

generative model + discriminative model(샘플이 데이터분포로부터 나온건지, 모델분포로부터 나온건지 결정하는 것을 학습하는 모델)

대표적 예시 2. Related work

DBN, GSN

더보기DBN, GSN 논문도 읽고 여기다 링크 달 것

3. Adversarial nets

adversarial modeling framework는 모델이 둘 다 다층 퍼셉트론일 때 가장 간단하게 적용됨

데이터 x를 통해 generator의 분포 Pg를 학습하기 위해선 입력 노이즈값인 Pz(z)를 사전에 정의해야함

그러고나서 G(z;θg)로 데이터 공간을 매핑해서 나타냄(여기서 G는 변수θg를 갖는 다층 퍼셉트론으로 표현되는 미분가능 함수)

ㅇ(x;θd)는 스칼라값을 output으로 냄

D(x)는 x가 Pg가 아닌 데이터에서 나올 확률을 나타냄

G로부터 나온 샘플들과 훈련 예시들 모두에 올바른 라벨을 할당할 확률을 최대화하도록 D를 훈련시킴

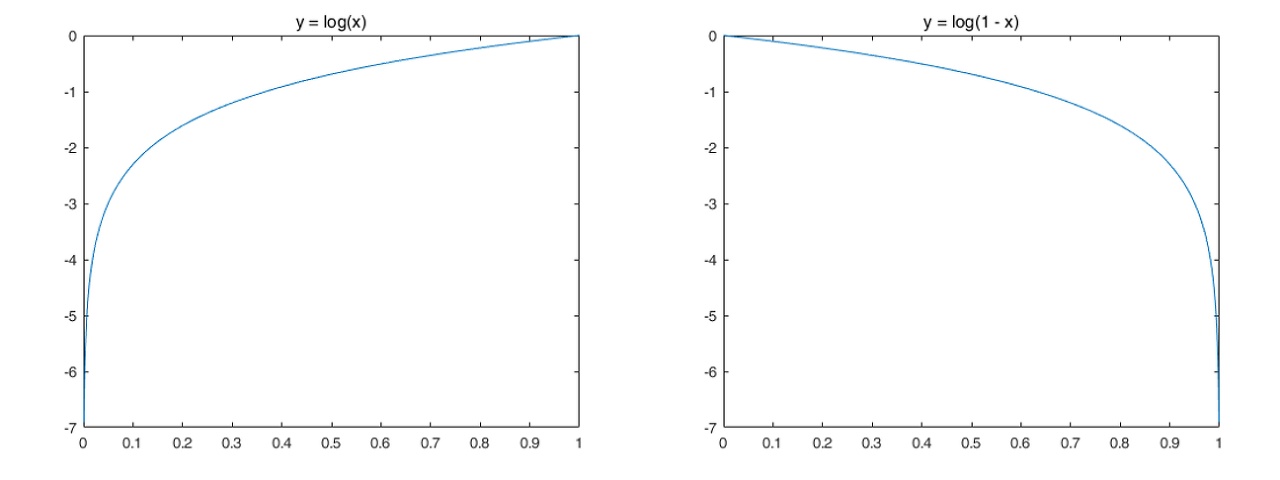

동시에 G는 log(1-D(G(z)))를 훈련시킴

=>D와 G는 가치함수 V에 대해 minimax game을 하는 것

D를 최적화하는 k단계와 G를 최적화하는 1단계를 번갈아가며 사용

why?D를 학습 루프동안 최적화하는 것은 계산적으로 불가능하고 제한된 데이터셋으로 overfitting이 될 수 있기 때문

근데 현실적으론 위의 식이 제대로 작동안함

why?G가 학습을 제대로 못 해서 일찍 학습을 멈췄을 때, D는 높은 확률로 얘네들을 거절할 거기 때문!

고치는 간단한 방법 = log(1-D(G(z)))를 logD(G(z))로 바꾸면 됨

'공부 > 논문' 카테고리의 다른 글

Segment Anything (0) 2024.08.03 An Image is worth 16*16 words: Transformers for image recognition at scale (0) 2024.06.06 StyleGAN 1~3 논문 리뷰 (1) 2024.03.19 Prompt-Specific Poisoning Attacks on Text-to-Image Generative Models(Nightshade) (1) 2024.02.22 VERY DEEP CONVOLUTIONAL NETWORKS FOR LARGE-SCALE IMAGE RECOGNITION(VGGNet) (0) 2024.02.18