-

Chapter3 왜 우리는 인공신경망을 공부해야하는가?교육/혁펜하임의 AI DEEP DIVE 2023. 1. 27. 14:51728x90

chapter3-1 인공신경망, weight와 bias의 직관적 이해, 인공신경망은 함수다!

인공신경망 예시 동그라미는 노드라 부르고 연결시켜주는 선들은 엣지(혹은 connection)이라고 부름

웨이트(중요도)를 곱하고 바이어스(민감도)와 함께 더하고 액티베이션 함수를 통과하여 출력하면 끝!

주어진 입력에 대해 원하는 출력이 나오도록 웨이트,바이어스를 정해줘야하는데 AI는 이를 스스로 알아냄

깊은 인공 신경망은 DNN, Deep Neural Network인데 그냥 히든레이어가 많아진다고 보면 됨

노드끼리 전부 연결한 층은 FC(Fully-connected)layer

모든 layer가 FC layer(예시 그림처럼)인 신경망을 MLP(Multilayer Perceptron)이라고 부름

chapter3-2 선형 회귀, 개념부터 알고리즘까지 step by step

ex)키와 몸무게의 관계(->함수)=ax+b라고 두고 a,b를 잘 추정해서 처음보는 키에 대해서도 적절한 몸무게를 출력하는 머신을 만들어보자

즉, 알아내야할 것은 최적의 웨이트, 바이어스를 데이터 기반으로 알아내야함

하지만 최적의 웨이트와 바이어스는 어떤 기준으로 판단??

=>loss funtion을 최소화하는 웨이트,바이어스가 최적ex)MSE(Mean squared error)=(머신의 예측-실제 값)^2

chapter3-3 gradient descent(경사 하강법)

웨이트와 바이어스는 아무렇게 정한 다음 현재 위치에서 Loss를 줄이는 방향으로 나아가자

gradient는 항상 가장 가파른 방향을 향한다

다음위치=현재위치-학습률*미분값

learning rate의 존재 이유는 gradient가 발산하지않도록 조절해주는 역할(상수로 정하기도하고 스케줄링하기도 함)

initial weight(LeCun,Xavier,He,...)

chapter3-4 가중치 초기화기법 정리

LeCun

Xacler(sigmoid/tanh 사용하는 신경망)

He(ReLu 사용하는 신경망)

chapter3-5 GD vs SGD(Stochastic Gradient descent)

기존의 우리가 경사하강법으로 구한 global minimum은 시간이 오래걸림(모든 데이터에 대한 Loss를 구하고 계산하기 때문)

반면 SGD는 데이터 하나당 그래디언트를 계산해서 움직이기 때문에 시간이 훨씬 절약됨

비복원 추출&다 뽑고 다시 비복원추출 반복

local minimum으로부터 탈출의 기회가 될 수도 있다

chapter3-6 mini-barch SGD

SGD는 하나씩만 보니까 너무 성급하게 방향이 결정됨=>mini-batch

GPU는 병렬 연산을 가능하게 하므로 여러 데이터에 대해서도 빠름

하지만 무작정 batch size를 키우진 말고 최대 8k정도까지만 학습률을 함께 키우면서 해야함

이후에는 에러율이 상승함(아마도 local minimum으로 빠질 가능성이 커져서)

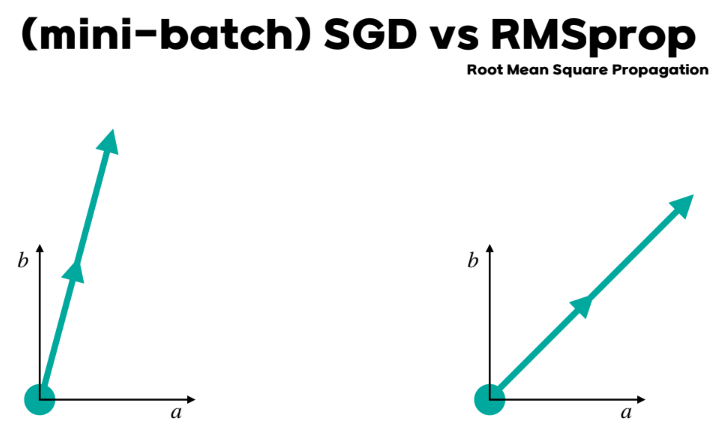

chapter3-7 Moment vs RMSProp

왼쪽이 mini-batch SGD 오른쪽이 momentum->그라디언트를 누적함으로써 관성을 가지게 함

많이 훑은 축으로는 적게 적게 훑은축으로는 많이 탐색(평준화를 통해 공평하게 탐색)

learning rate를 각 파라미터 별로 다르게 준셈(경사가 너무 가파로운 쪽은 조심조심, 완만한 쪽은 과감하게)

chapter3-8 Adam

chapter3-9 Training vs Test vs Validation(AI의 목표는?Validation이 중요한 이유)

Training vs Test(vs Validation)

파라미터 학습을 위한 data vs 최종적으로 학습된 모델 테스트용 data( vs 하이퍼파라미터 선택을 위한 data)

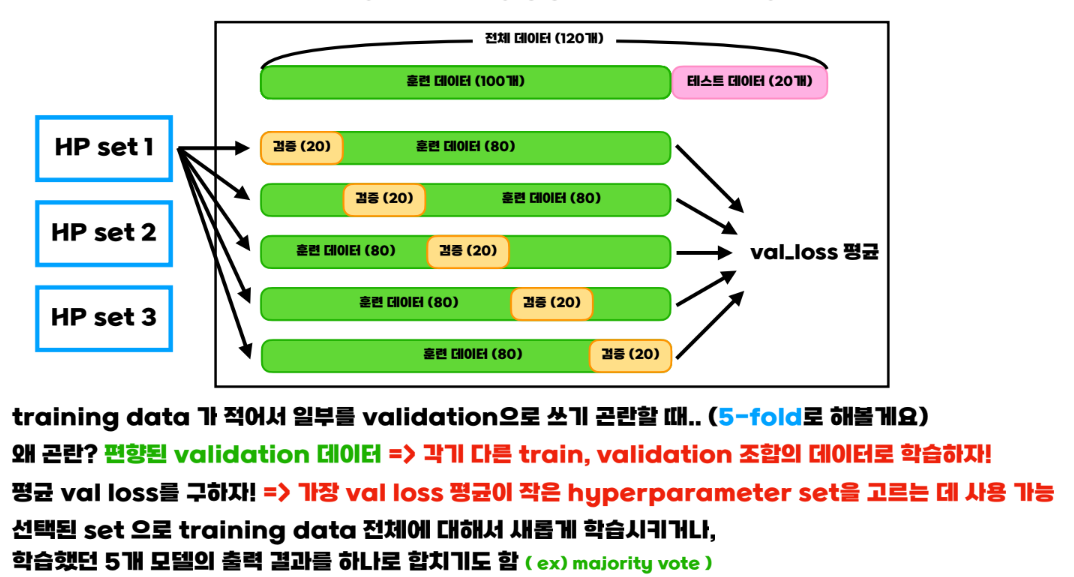

chapter3-10 K-fold Cross Validation

본 게시글은 패스트캠퍼스 [혁펜하임의 AI DEEP DIVE] 체험단 활동을 위해 작성되었습니다.

'교육 > 혁펜하임의 AI DEEP DIVE' 카테고리의 다른 글

Chapter6 인공신경망, 그 한계는 어디까지인가? (0) 2023.02.06 Chapter5 이진분류와 다중분류 (0) 2023.02.05 Chapter4 딥러닝, 그것이 알고싶다. (0) 2023.02.02 Chapter2 왜 현재 AI가 가장 핫할까? (2) 2023.01.27 Chapter1 딥러닝을 위한 필수 기초 수학 (0) 2023.01.23